AI 코드리뷰 서비스 비교 (feat. 개인 경험 & 딥리서치)

AI 코드리뷰 서비스들은 '거시적 관점'과 '누락 작업 탐지'가 부족하다는 제 인상이 정말인지 딥리서치를 돌려봤습니다.

어제 Cursor가 1.0으로 업데이트되면서 BugBot이라는 또 하나의 AI 코드리뷰 서비스가 나왔습니다.

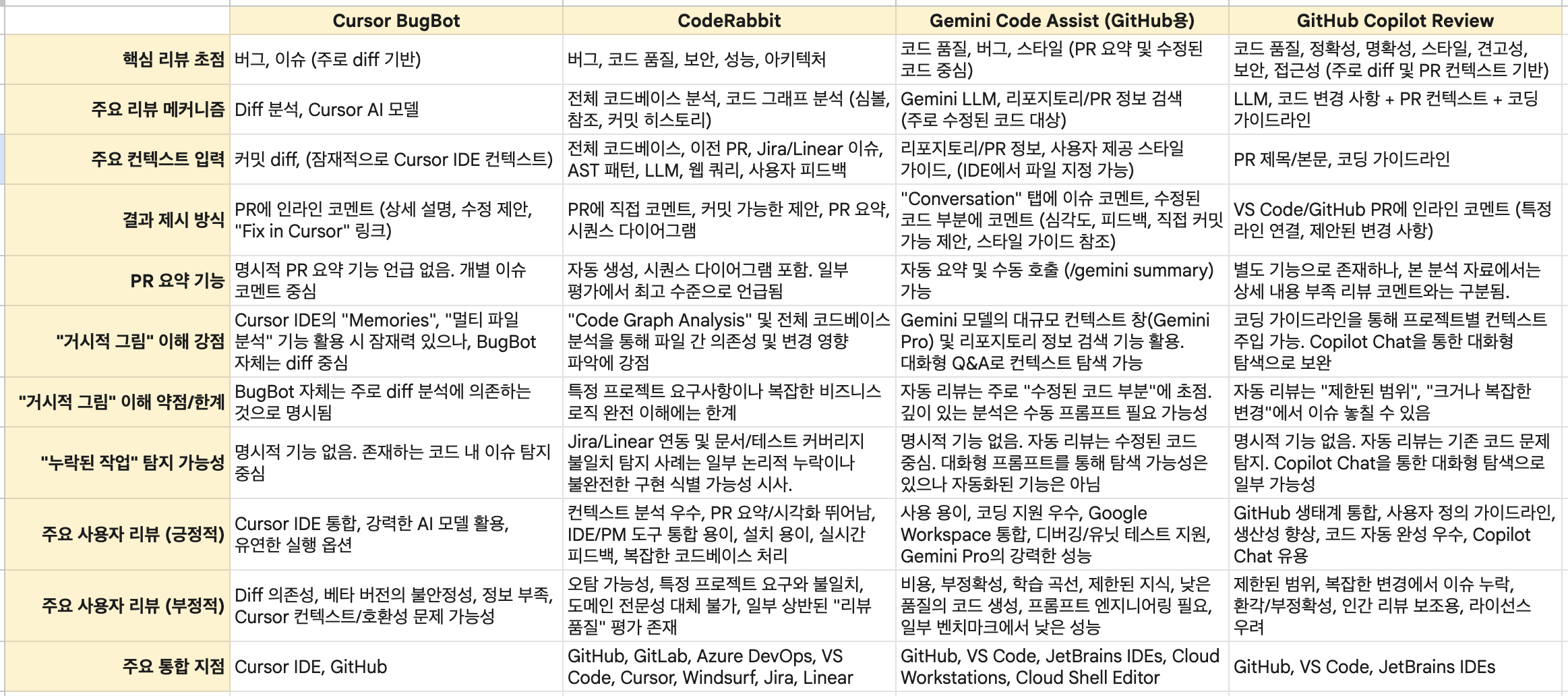

BugBot을 몇 개 PR에서 써보면서, 지난 AI 코드리뷰 서비스 경험을 종합해 짧은 글을 하나 썼어요. 참고로 아래 글에서 언급한 4개 서비스의 사용 경험은 이렇습니다.

- CodeRabbit: 개인/회사 계정에서 (무료 버전으로만) 1년쯤 써봄

- GitHub Copilot Review: 회사 계정에서 한달 정도 써봄

- Gemini Code Assist: 개인 계정에서 몇 번 써봄

- Cursor BugBot: 회사 계정에서 몇 번 써봄

코드래빗/제미니 코드 어시스트/코파일럿 리뷰와 비교할 때 기능의 풍부함은 버그봇이 가장 적습니다.

우선 버그봇은 '리뷰'보다는 '버그 찾기'에 더 집중한 것으로 보입니다. 리뷰가 많지 않아요. 그리고 인라인 리뷰 대신 한 코멘트에 모든 리뷰가 달리는 식이라서, 커서로 다시 돌아가지 않으면 맥락을 알기 어렵습니다. 코드래빗같은 요약이나 워크플로우 그림 기능도 당연히 없고요.

근데 사실 코드래빗의 요약과 워크플로우가 좋냐 하면 그건 아니었어서.. 이건 딱히 아쉽진 않았습니다. 그럴듯한 헛소리인 경우가 많더군요.

결국 버그봇이 집중한대로 버그를 정말 잘 잡아내는가가 중요한데, 이건 아직은 잘 모르겠습니다. 애매했어요. 그리고 무엇보다...

제가 버그봇을 비롯한 AI 리뷰 서비스들에게 공통적으로 가지는 불만은 diff에 지나치게 의존한다는 겁니다. 즉 '고친 부분'에서 잘못된 건 어느정도 찾아주는데, '고쳤어야 하는데 안 고친 부분'은 찾아주지 못해요. 큰 그림을 보는 것도 아주 약하고요. 사실 이것들은 인간이 리뷰할 때도 어려운 부분이라 AI에게 기대하는 게 좀 지나친 것 같긴 합니다만.

그러면 이걸 AI 리뷰가 해줄 수 있냐? (답답하면 니가 만들거냐?) 하면 솔직히 아닌 것 같아요. 이부분을 AI가 해주려면 결국 리뷰가 아니라 구현 단에서 신경을 써야 하는 거 아닌가 싶거든요.

클로드 코드 같은 걸로 컨텍스트를 잘 먹이고(이 제품은 뭘 하는 제품이다, 구조는 이렇다, 이번 기능을 구현하려면 어디어디를 고쳐야 한다 등) 테스트 빡세게 짠 다음 통과시키는 프롬프팅하는 게 코드리뷰 서비스보다 나을 것 같다는.

그래서 결론은, 아직은 AI 코드리뷰 서비스에 돈을 쓰거나, 내가 만들고 싶진 않다는 거. 컨텍스트가 엄청 큰 제미니 코드 어시스트가 이쪽으로도 더 발전해주면 좋겠네요.

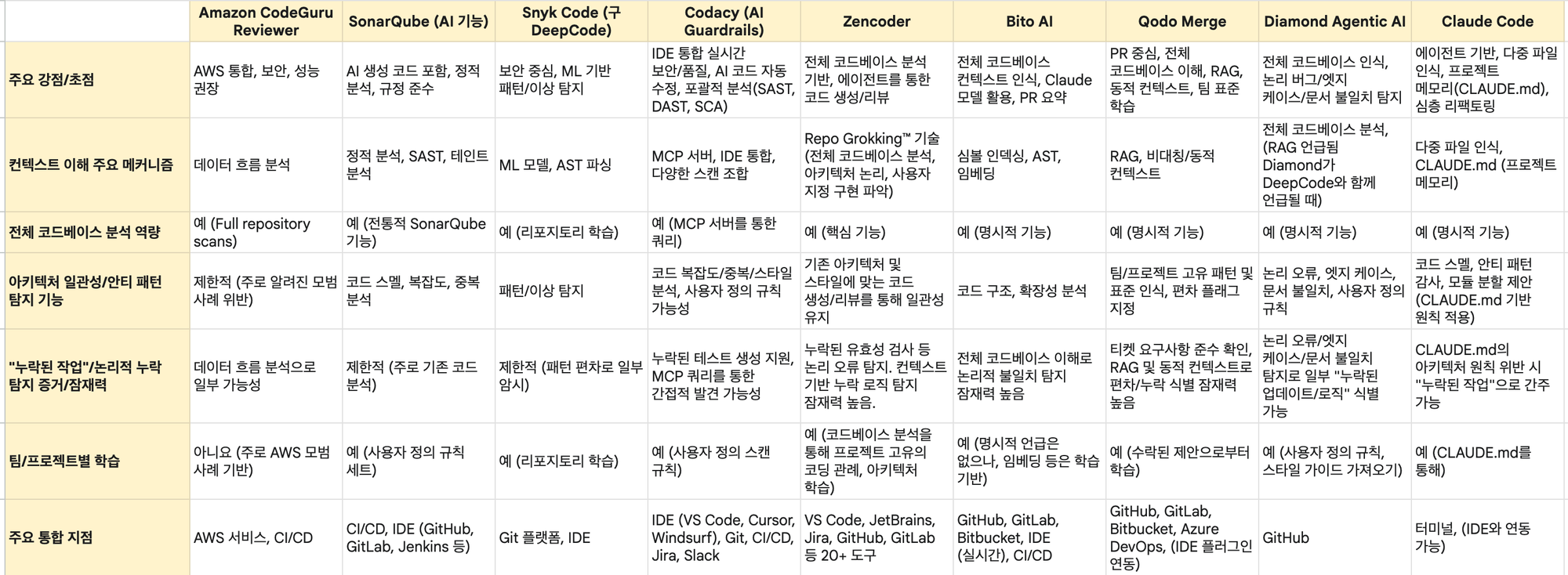

그런데 이렇게 쓰고 보니, 평가하기에는 아무래도 제 경험이 너무 얕다는 생각이 들었습니다. 그래서 '거시적 관점'과 '누락된 작업 탐지'와 관련해서 정말 코드리뷰 서비스들이 잘 못 하나? 라는 의문을 가지고 딥리서치를 3번 돌렸어요. (Perplexity로 1번, Gemini로 2번)

결과적으로 Perplexity는 큰 도움은 되지 않았고, Gemini의 2개 분석에서 (Gemini Code Assist가 비싸다는둥 환각 현상이 좀 있긴 헀으나) 꽤 다른 서비스들을 다뤄준 게 재미있었습니다. 제가 써본 것 중에서는 CodeRabbit이 '거시적 관점'과 '누락 작업 탐지'에서 가장 가능성이 높아 보이더군요.

제가 "다른 유망한 서비스도 조사해달라"고 해서 그런지 제가 잘 몰랐던 다른 서비스들도 많이 튀어나온 것도 좋은 수확입니다. 언급된 서비스 중에서는 이렇게 4개가 나쁘지 않아보이더군요. 기회가 되면 다 무료 버전 정도는 써보고 후기를 남기고 싶은데 시간이 될지 모르겠네요 😂

프롬프트 & 리서치 결과 문서 (구독자 전용)

구독자 분들을 위해 리서치 프롬프트 및 결과 문서도 공유드립니다. 👇